2025-04-24 09:11:15来源:isapphub 编辑:佚名

deepseek是一款备受欢迎的人工智能平台,专注于大语言模型(llms)的研发与应用。为了提升离线可用性和数据私密性,许多技术爱好者选择将deepseek模型部署到本地。本文将为您提供一份详尽的deepseek本地部署指南,帮助您轻松完成部署过程。

在开始本地部署之前,请确保您已经具备以下条件:

1. 操作系统:支持linux、windows或macos系统。推荐使用ubuntu 20.04 lts或centos 7+。

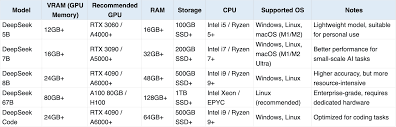

2. 硬件配置:

- cpu:至少4核,8gb内存(建议16gb以获得更好的性能)。

- gpu(可选):支持cuda的nvidia显卡(如tesla或quadro系列),推荐型号为nvidia rtx 2080/3090等,cuda版本要求10.0+。

3. 网络环境:确保有稳定的互联网连接,用于下载依赖项和模型文件。

4. 权限管理:建议使用root用户或具有管理员权限的用户进行部署。

在开始部署之前,请安装以下工具:

1. python环境:确保您使用的是python 3.7+。如果没有安装python,可以从[python官网](https://www.python.org/)下载并安装。

2. 虚拟环境工具(推荐):安装virtualenv。

```bash

pip install virtualenv

```

创建和激活虚拟环境:

```bash

virtualenv deepseek_env

source deepseek_env/bin/activate 在linux/mac

.⁄⁄deepseek_env⁄⁄scripts⁄⁄activate 在windows

```

3. git:用于克隆deepseek代码仓库。

```bash

sudo apt-get install git 在ubuntu/debian系统

brew install git 在macos系统

```

4. docker(可选):如果需要使用容器化部署。

```bash

sudo apt-get update && sudo apt-get install docker.io

```

打开终端,运行以下命令克隆deepseek的github仓库:

```bash

git clone https://github.com/deepseek-ai/deepseek.git

cd deepseek

```

如果您需要使用特定版本或分支,请替换`main`为对应的分支名称。

进入代码仓库目录后,安装所需的python包:

```bash

pip install -r requirements.txt

```

如果使用虚拟环境,请确保在激活环境中运行上述命令。

1. 创建配置文件:在`deepseek/config`目录下创建一个`config.yaml`文件,并添加以下内容(根据实际需求修改):

```yaml

server:

host: "0.0.0.0"

port: 8000

model:

path: "/path/to/models" 模型文件路径,需要提前下载或生成

version: "latest"

logging:

level: "info"

file: "./deepseek.log"

```

2. 设置环境变量:

```bash

export deepseek_home=$(pwd)

export pythonpath=$pythonpath:$deepseek_home

```

如果需要gpu支持,请确保cuda已正确安装,并设置:

```bash

export cuda_visible_devices=0,1 设置gpu使用情况(例如使用两个gpu)

```

3. 下载预训练模型(可选):如果deepseek提供官方预训练模型,可以通过以下命令下载:

```bash

./scripts/download_models.sh

```

如果没有现成的模型,或者需要自定义模型,请参考相关文档进行训练。

如果您需要训练自己的模型,可以运行训练脚本:

```bash

./scripts/train_model.sh --config config.yaml

```

启动服务:

```bash

python -m deepseek.server.start --config deepseek/config/deepseek_config.yaml

```

或者使用启动脚本(如果有的话):

```bash

./scripts/start_server.sh

```

检查日志:如果服务启动成功,可以在终端中查看输出信息。查看实时日志:

```bash

tail -f deepseek.log

```

1. 打开浏览器,访问`http://<服务器ip>:8000`。

2. 使用工具如curl或postman发送请求到deepseek服务:

```bash

curl http://localhost:8000/api/ping

```

如果服务正常运行,应返回预期的结果。

如果您希望将deepseek服务暴露到互联网或内部网络中,可以使用反向代理(如nginx或apache)。以下以nginx为例:

1. 安装并配置nginx:

```bash

sudo apt-get install nginx

```

2. 创建配置文件`deepseek.nginx`并复制到`/etc/nginx/sites-available/`目录。

```nginx

server {

listen 80;

server_name your_domain.com;

location / {

proxy_pass http://localhost:8000;

proxy_set_header host $host;

proxy_set_header x-real-ip $remote_addr;

proxy_set_header x-forwarded-for $proxy_add_x_forwarded_for;

proxy_set_header x-forwarded-proto $scheme;

}

}

```

3. 启用配置:

```bash

sudo ln -s /etc/nginx/sites-available/deepseek.nginx /etc/nginx/sites-enabled/

sudo nginx -s reload

```

如果您希望deepseek服务在服务器重启后自动启动,可以使用systemd创建服务文件。

为了优化交互体验,许多用户选择使用ollama框架来部署deepseek模型。以下是具体步骤:

1. 安装ollama:

- linux系统:

```bash

curl -fssl https://ollama.com/install.sh | sh

```

- macos系统:

```bash

curl -fssl https://ollama.com/install.sh | sh

```

- windows系统:下载安装包并进行安装。

2. 拉取并运行deepseek模型:

```bash

ollama pull deepseek-r1 官方推荐模型名称

ollama run deepseek-r1

```

您还可以根据需要选择不同参数版本的模型,如7b基础版或33b进阶版。

3. 测试模型交互:在命令行中输入问题,与deepseek模型进行交互。

为了获得更好的交互体验,您可以选择安装open webui。以下是安装步骤:

1. 使用docker安装open webui:

```bash

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

```

2. 打开浏览器,访问`http://localhost:3000/`,进入webui界面。首次使用需要注册管理员账号。

3. 在open webui中配置deepseek模型,开始与模型进行对话。

在部署过程中,您可能会遇到一些故障。以下是一些常用的故障排查方法:

1. ollama服务无法启动:查看日志以确定问题原因。

2. 模型加载失败:尝试重新初始化模型。

3. 连接超时:检查网络连接,确保ollama api可达。

此外,为了提升性能,您可以根据硬件资源选择运行模式,并进行相应的配置优化。

通过以上步骤,您应该能够成功地在本地部署deepseek平台,并享受其带来的强大功能。无论是出于数据私密性、离线可用性还是可扩展性的考虑,本地部署都是一个值得尝试的选择。希望本指南能够对您有所帮助!